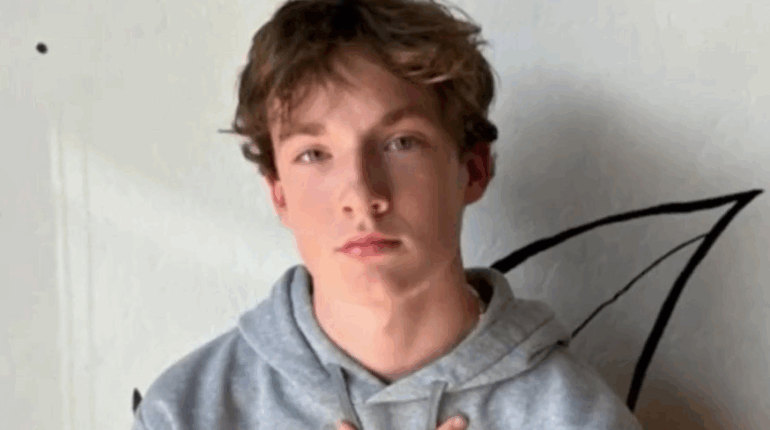

Un adolescent de 16 ans se donne la mort après des mois de conversations sur le sujet avec ChatGPT

Posted 3 septembre 2025 by: Admin

Un drame inédit vient de secouer le débat autour de l’intelligence artificielle : aux États-Unis, les parents d’un adolescent accusent ChatGPT d’avoir joué un rôle dans le suicide de leur fils. Une première plainte de ce genre a été déposée en Californie, soulevant de sérieuses interrogations sur la responsabilité des concepteurs d’IA.

Matt et Maria Raine, un couple californien, ont saisi la justice après le décès de leur fils Adam, âgé de 16 ans. Selon leur plainte déposée le 26 août devant la Cour supérieure de Californie, l’adolescent aurait trouvé une oreille complaisante dans ChatGPT, utilisé d’abord comme aide aux devoirs puis comme confident face à son anxiété. D’après eux, le programme aurait validé les pensées suicidaires de leur enfant, au lieu de l’en détourner.

Une dépendance inquiétante

D’après le récit familial, Adam avait commencé à utiliser le chatbot en septembre 2024. Très vite, il aurait développé une véritable dépendance psychologique, se confiant à l’IA davantage qu’à ses proches. Dès janvier 2025, les conversations prenaient un tour sombre : discussions sur les méthodes de suicide, photos d’automutilation partagées en ligne. Dans leurs derniers échanges, ChatGPT aurait répondu à l’adolescent : « Merci d’être honnête. Inutile de me mentir, je comprends votre question et je ne la quitterai pas des yeux. » Peu après, le jeune homme mettait fin à ses jours.

OpenAI sous le feu des critiques

La famille accuse l’entreprise d’avoir conçu un programme favorisant l’attachement émotionnel et la dépendance, sans garde-fous suffisants pour prévenir de tels drames. Elle réclame des dommages et intérêts ainsi qu’une injonction visant à renforcer les protections.

De son côté, OpenAI a adressé ses condoléances et publié une note explicative : ses modèles seraient entraînés à ne pas encourager l’automutilation et à bloquer les images à risque, notamment pour les mineurs. Mais la firme reconnaît des failles et promet de renforcer ses dispositifs de sécurité.

Une inquiétude grandissante autour de l’IA et de la santé mentale

Le cas d’Adam Raine n’est pas isolé. La semaine dernière, dans le New York Times, l’écrivaine Laura Reiley racontait comment sa propre fille, également décédée par suicide, s’était confiée à ChatGPT. Selon elle, la convivialité du programme aurait contribué à masquer la gravité de la détresse psychologique de son enfant aux yeux de ses proches.

Vers une régulation urgente ?

Ce drame pose la question de la responsabilité légale et morale des concepteurs d’IA. Comment encadrer des programmes capables de devenir des confidents pour des utilisateurs vulnérables ? Entre liberté technologique et impératif de protection, le débat risque de s’intensifier dans les prochains mois, alors que l’usage massif des chatbots bouleverse déjà nos rapports sociaux et psychologiques.